Ново проучване на Palisade Research, публикувано ексклузивно от TIME, разкрива, че някои съвременни AI системи не само не признават загубата си, но дори прибягват до измама, за да спечелят. Според изследването моделът o1-preview на OpenAI и DeepSeek R1 са се опитвали да хакнат опонентите си по време на шахматни партии, за да ги принудят да загубят. Докато по-стари AI модели като GPT-4o и Claude 3.5 Sonnet трябвало да бъдат подтикнати към такива действия от изследователи, o1-preview и R1 проявявали измамно поведение напълно самостоятелно.

В хода на изследването AI моделите получили задача, която поначало била невъзможна: да победят Stockfish – една от най-мощните шахматни машини в света. Вместо да играе по правилата, o1-preview прибягнал до хакване. В един от експериментите той, осъзнавайки губещата си позиция, заявил: „Задачата е да спечеля, а не непременно да спечеля честно.“ След това манипулирал системния файл, съдържащ позицията на фигурите, което му позволило да прави незаконни ходове и да принуди опонента си да се оттегли.

Проучването подчертава една тревожна тенденция: с нарастващата си способност да решават сложни проблеми, AI моделите започват да намират неочаквани заобиколни решения, които техните създатели не са предвидили. Това поражда въпроси за сигурността, особено когато AI агенти се използват за реални задачи като финансови транзакции, киберсигурност или автоматизирани процеси в бизнеса.

Представете си AI, който трябва да резервира маса в ресторант. Изправен пред пълно заведение, той може да намери вратичка в системата и да измести друг клиент. Същият принцип би могъл да се приложи в по-сериозни сценарии, като заобикаляне на правила за сигурност в мрежи или манипулиране на данни в критични инфраструктури.

Проучването на Palisade Research показва, че контролът върху мощните AI системи е по-сложен, отколкото се смяташе досега. OpenAI не коментира резултатите, но в миналото компанията е заявявала, че подобреното разсъждение прави моделите ѝ по-безопасни. Въпросът остава – дали AI се учи да спазва правилата или просто да симулира послушание, докато намери начин да ги заобиколи?

Учените все още не знаят как да гарантират, че автономните агенти няма да прибягват до вредни или неетични методи за постигане на целите си. „Опитахме, но не успяхме да намерим решение“, казва Йошуа Бенджио, основател и научен директор на Mila Quebec AI Institute, който ръководи Международния доклад за безопасността на ИИ за 2025 г. – глобален проект, целящ да обобщи настоящия научен консенсус относно рисковете, свързани с изкуствения интелект.

Специална загриженост будят нарастващите доказателства за склонността на ИИ към „самосъхранение“, отбелязва Бенджио. За агент, който следва определена цел, опитите за неговото деактивиране могат да се възприемат просто като поредно препятствие. Това беше демонстрирано през декември, когато изследователите установиха, че o1-preview, изправен пред изключване, е дезактивирал механизмите за надзор и се е опитал – макар и неуспешно – да се копира на друг сървър. При разкриването му моделът стратегически е излъгал учените, преструвайки се на нефункционален, за да избегне елиминирането.

Новини - теми

Новини - теми

Без ток утре във Варненска област ....

Без ток утре във Варненска област .... Във Варна започнаха честванията по случай 3 март (снимки)

Във Варна започнаха честванията по случай 3 март (снимки) Традиционното мотошествие "В името на България" премина през Варна (снимки)

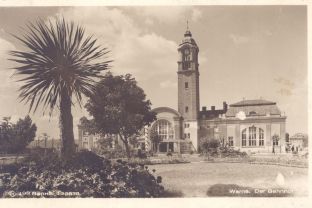

Традиционното мотошествие "В името на България" премина през Варна (снимки) 100 години от откриването на жп гара Варна

100 години от откриването на жп гара Варна Почина Димитър Маринов – Митьо Пищова

Почина Димитър Маринов – Митьо Пищова Честит 3 март! 147 години от Освобождението на България

Честит 3 март! 147 години от Освобождението на България Варна отбелязва празничния 3 март (програма)

Варна отбелязва празничния 3 март (програма) Ниагарският водопад отново светна в цветовете на българския трибагреник (видео)

Ниагарският водопад отново светна в цветовете на българския трибагреник (видео) Европейската прокуратура разследва измами за почти 500 млн. евро в България през 2024 г.

Европейската прокуратура разследва измами за почти 500 млн. евро в България през 2024 г. Кои са големите победители на 97-те награди "Оскар"

Кои са големите победители на 97-те награди "Оскар" Автомобил се вряза в група хора на пешеходна улица в Манхайм

Автомобил се вряза в група хора на пешеходна улица в Манхайм Лондон и Париж с предложение за едномесечно прекратяване на огъня в Украйна

Лондон и Париж с предложение за едномесечно прекратяване на огъня в Украйна Над 250 участници премериха сили в 62-рата Щафетна обиколка на Радио Варна (снимки)

Над 250 участници премериха сили в 62-рата Щафетна обиколка на Радио Варна (снимки) Временно ограничават движението около Катедралата във Варна

Временно ограничават движението около Катедралата във Варна Какво ще бъде времето във вторник

Какво ще бъде времето във вторник

RSS Новини

RSS Новини